Exemple de capture de site avec HTTrack

Testée avec la version WinHTTrack Website Copier 3.30-RC-4 (+swf)

Canobie juin 2003

nom du projet : canobieadresse Web(URL) : http://www.canobie.com

durée de la capture : 1/2 heure (modem 56k)

problèmes :

- Fichiers manquants ou incomplets,

- balise <META NAME="ROBOTS" CONTENT="NOINDEX, NOFOLLOW">

- fichier robots.txt

Autres exemples avec des difficultés similaires : Martin Luther King 2002 | Martin Luther King 2004 | Recycling | Extreme World | Herberton

solutions :

- En fin de capture, de nombreuses images et fichiers pdf manquent.

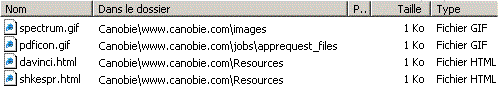

L'examen du fichier journal d'HTTrack fait apparaître :

Ce site qui ne posait pas de problème de capture l'an dernier encore veut limiter l'accès des aspirateurs de sites. Il faut croire que certains ont dû exagérer et n'ont pas limité le nombre de connexions, le taux maximal etc!!!

On ouvre donc un des fichiers comportant une balise meta limitant la capture et on trouve :<META NAME="ROBOTS" CONTENT="NOINDEX, NOFOLLOW">

Cette balise est présente dans tous les fichiers qui n'ont pas été scannés.

Lisez la page sur les pièges à robots, puis sélectionnez dans l'onglet fouineur

pas de règles robots.txt

Un bref examen du site permet de dire que les répertoires interdits dans le fichier robots.txt ne présentent pas d'intérêt, s'ils existent.

Pour éviter de tomber dans un piège à robots, interdisez ces répertoires dans les règles de filtrage :

-*/cgi-bin/*

-*/stats/* et ainsi de suite.

Plusieurs avantages : limiter la capture, éviter de surcharger le serveur en téléchargeant des fichier inutiles et éviter d'être bloqué si un de ces sous répertoire contient un script destiné à ceux qui ne respectent pas les règles.

On relance alors la capture

- En fin de capture, une partie des fichiers manque encore.

L'examen du fichier journal d'HTTrack fait apparaître :

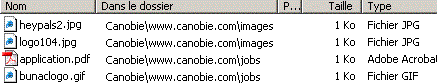

Avec l'explorateur on recherche les fichiers contenant le texte "404 FILE NOT FOUND" et on trouve

On recherche ensuite les fichiers contenant le texte "400 Bad Request" et on trouve

Deux solutions à ce stade : -

- On visite sur le site les pages manquantes et celles comportant les images absentes puis on récupère les fichiers dans le cache d'Internet Explorer, on ôte le chiffre et les crochets [1] ajoutés lors de la copie afin de remplacer les fichiers en erreur.

- On visite et on enregistre les images, les pages et le fichier pdf dans le bon répertoire à partir d'Internet Explorer (clic droit / Enregistrer l'image sous, clic droit / Enregistrer la cible sous, Fichier / Enregistrer sous).

La capture est exploitable avec des élèves.

Haut de la page

Haut de la page