Exemple de capture de site avec HTTrack

Extreme World novembre 2002

nom du projet : extremeworldadresse Web(URL) : www.extremeworld.com

durée de la capture : 1 heure (modem 56k)

ajoutez dans règles de filtrage :

-*.rm (si on ne veut pas des vidéos Realplayer)

Lisez la page sur les pièges à robots,

puis sélectionnez dans l'onglet fouineur

pas de règles robots.txt

problèmes :

- Images et fichiers vidéo absents à cause d'un fichier robots.txt

- diaporamas en javascript

Autres exemples avec des difficultés similaires : Alton Towers | Herberton | Martin Luther King 2004 | Martin Luther King 2002 | Recycling | Canobie

solutions :

- En fin de capture, si l'option "pas de règles robots.txt" n'a pas été sélectionnée, une grande partie des images et les vidéos manquent.

Effectuez donc la sélection et relancez la capture. - Les diaporamas ne font apparaître que la première image. C'est une routine en javascript dont les liens ont bien été réécrits qui assure le passage d'une image à l'autre.

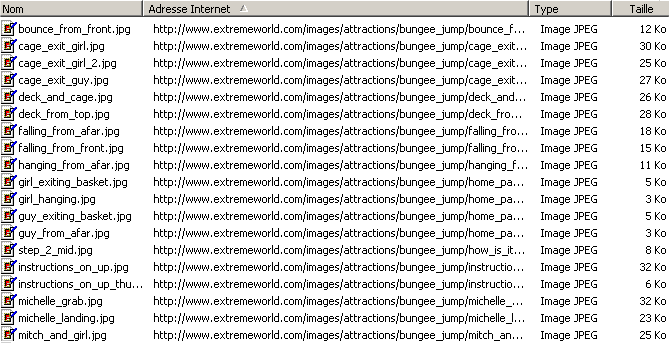

Il est donc nécessaire de visiter le site afin de charger toutes images en parcourant tous les diaporamas. - Dans le cache (Temporary Internet Files) on trouve à peu près cela :

Il faut copier les images de tous les diaporamas (ici celui du bungee jump) dans les répertoires de la capture, puis ôter [1] dans les noms de fichiers.

La capture est maintenant exploitable avec des élèves.

Haut de la page

Haut de la page